Je vous en avais parlé il y a quelques mois sur Twitter/X (cf post en photo). Le projet Gotham de Palantir, aujourd’hui l’un des systèmes les plus avancés au monde pour transformer des flux de données brutes en décisions opérationnelles.

Sous le capot, Gotham n’est pas juste une base de données géante : c’est une architecture d’analyse distribuée, pensée pour la corrélation en temps réel d’événements, de signaux et d’entités.

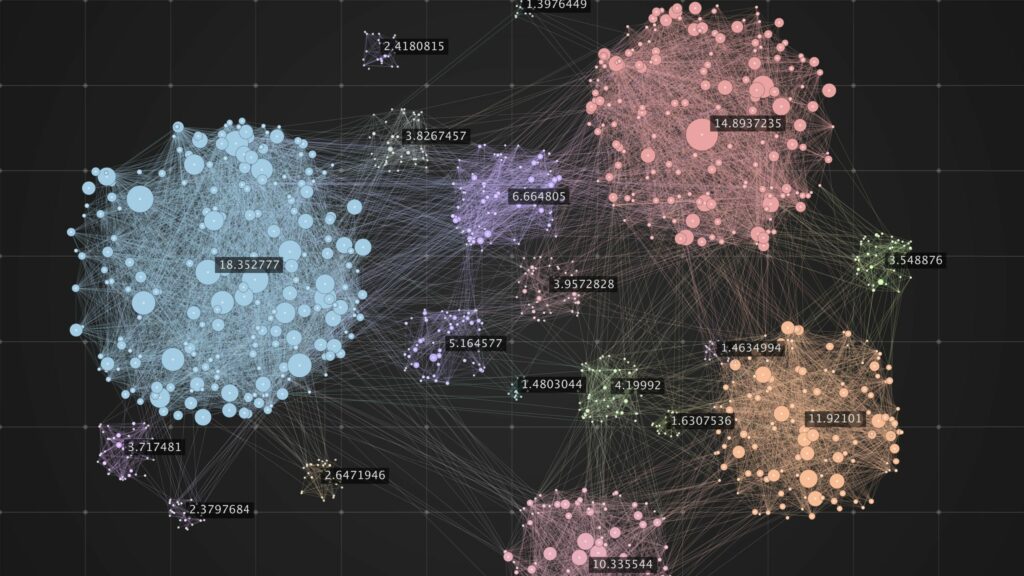

Derrière cette capacité se cache une architecture pensée pour le raisonnement. Gotham ne traite pas la donnée sous forme de tableaux ou de requêtes SQL classiques, mais comme un graphe dynamique où chaque entité — un individu, un lieu, une transaction, un événement — est reliée à d’autres par des relations pondérées, enrichies et contextualisées. Ce graphe évolue en temps réel, et c’est à partir de ces relations que le moteur d’IA calcule des probabilités, des tendances et des scénarios futurs.

Le cœur du dispositif prédictif repose sur deux couches : un moteur de corrélation et une couche de modélisation comportementale. Le moteur de corrélation analyse la densité et la récurrence des interactions : combien de fois tel acteur apparaît dans tel type d’événement, à quelle fréquence, avec quels décalages temporels, et dans quels contextes géographiques.

À partir de là, Gotham construit des vecteurs de comportement qui servent de base à l’apprentissage automatique. Ces vecteurs nourrissent des modèles supervisés et non supervisés capables de reconnaître des patterns — par exemple, la séquence typique d’activités précédant une cyberattaque, un sabotage industriel ou une opération militaire.

La couche prédictive ne se limite pas à l’alerte. Gotham est capable de simuler des scénarios. Lorsqu’un utilisateur modifie une variable — par exemple, la fermeture d’une route stratégique, une variation du prix d’un matériau ou le déploiement d’une unité — le système peut recalculer l’impact de ce changement sur l’ensemble du graphe, en évaluant la probabilité de conséquences indirectes. Cette approche s’apparente à une forme d’“IA contrefactuelle” : Gotham peut répondre non seulement à “que se passe-t-il maintenant ?”, mais à “que se passerait-il si… ?”.

Techniquement, cette capacité repose sur des modèles de séries temporelles, des graph neural networks et des techniques de propagation d’influence. Les nœuds du graphe sont vectorisés, les relations sont pondérées, et des algorithmes de diffusion simulent l’évolution d’un événement dans le temps.

Enfin, Palantir a ajouté à Gotham une surcouche d’interaction en langage naturel, connectée à son écosystème AIP (Artificial Intelligence Platform). Cette couche permet de traduire une intention humaine — “quelles sont les zones les plus à risque d’instabilité dans les trois prochains mois ?” — en une suite de calculs analytiques : filtrage des sources pertinentes, extraction d’entités, inférence probabiliste, et restitution sous forme visuelle. Le système ne se contente donc plus d’être un outil d’analyse, mais devient une interface de raisonnement, où l’utilisateur dialogue directement avec la donnée.

L’aspect prédictif de Gotham ne relève donc pas de la magie, mais de la combinaison de trois éléments : une modélisation sémantique par graphes, une exploitation d’IA distribuée et contextualisée, et une capacité à simuler l’impact d’événements dans un système complexe. Là où la plupart des outils de data science cherchent à expliquer le passé, Gotham vise à éclairer le futur.

Mais cette promesse de prédiction, aussi séduisante soit-elle, porte en elle un risque fondamental : celui de confondre prévoir et préempter. Quand une machine estime qu’un comportement “pourrait” mener à un risque, que fait-on de cette information ? La traite-t-on comme une hypothèse à examiner — ou comme une vérité anticipée à neutraliser ?

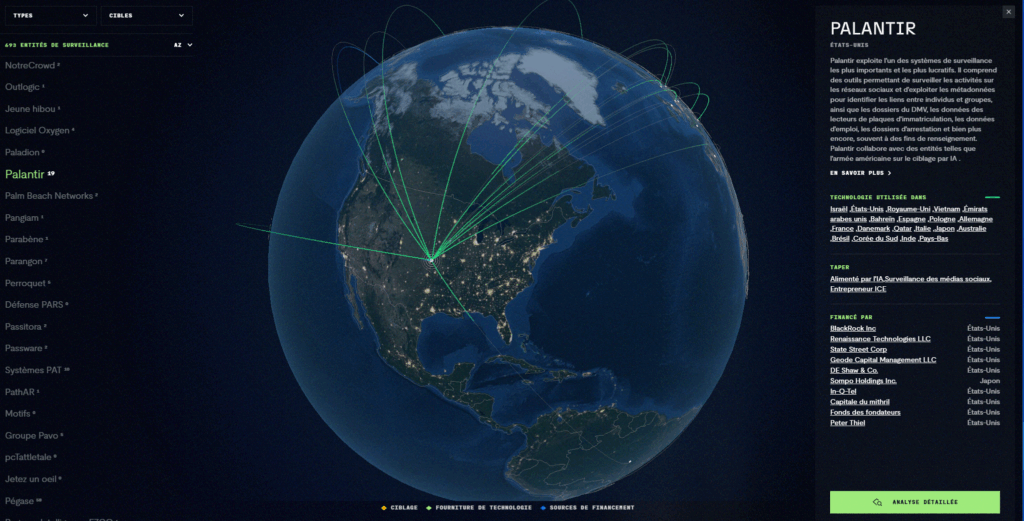

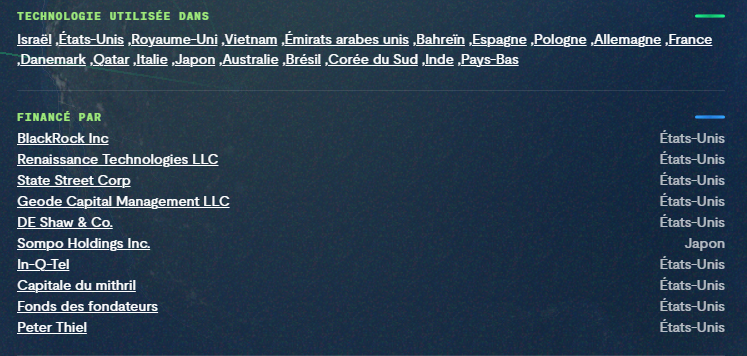

C’est là que Gotham, et plus largement Palantir, soulèvent des questions essentielles sur la gouvernance des données et des modèles. Car une prédiction, aussi sophistiquée soit-elle, n’est jamais qu’une probabilité, façonnée par les biais des données d’entrée et des hypothèses intégrées au système. Or, lorsqu’un outil aussi puissant est utilisé dans des contextes militaires, sécuritaires ou politiques, ces biais peuvent avoir des conséquences réelles sur des individus, des populations ou des décisions d’État.

Certes, Palantir Gotham impressionne par sa puissance technique. Il est capable d’ingérer des flux d’informations colossaux, de détecter des motifs invisibles, de projeter des scénarios alternatifs. Mais il est aussi le reflet d’une dérive plus large : celle d’un monde qui, sous couvert d’efficacité, délègue sa compréhension du présent et ses décisions sur l’avenir à des systèmes algorithmiques.

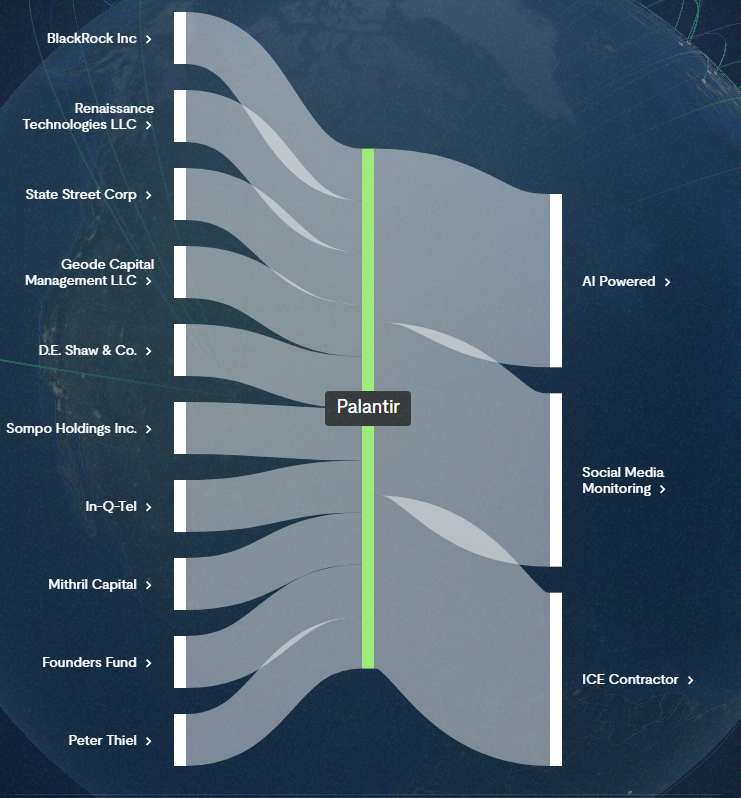

Le paradoxe est violent : Palantir vend la promesse de prédire le monde pour mieux le protéger, mais ceux qui la financent y voient surtout une opportunité de le contrôler. Le capital-risque, les fonds d’investissement et certains acteurs de la tech ne cherchent pas à rendre la société plus résiliente, ils cherchent à créer de la dépendance.